Hoe kan je pagina’s laten indexeren door zoekmachines

Iedereen wil het hoogst scoren in zoekmachines zoals Google. Ook hier geldt Darwins evolutietheorie. Survival of the Fittest. Oké, toegegeven: deze vergelijking is wat vergezocht, maar Google toont wel degelijk de meest relevante pagina’s bij een zoekopdracht bovenaan.

Content SEO is daar een belangrijk onderdeel van, daarnaast heb je ook nog heel wat technische SEO-toepassingen die de zichtbaarheid zullen vergroten. We schreven al enkele tips over technische SEO-toepassingen zoals paginasnelheid, mobile first indexing. In dit artikel zoomen we in op het crawlen en indexeren van pagina’s.

Wat is het verschil tussen crawlen en indexeren?

Crawlen is het proces waarbij zoekmachines, zoals Google, gaan ontdekken welke nieuwe & bestaande webpagina’s op het internet staan. Voor dit ontdekkingsproces baseren zoekmachines zich op sitemaps die websitebeheerders aanmaken. Daarnaast ontdekken zoekmachines ook nieuwe pagina’s door links te volgen op webpagina’s. Dit crawlproces wordt uitgevoerd door crawlers, ook wel bots genoemd.

Indexeren is het proces waarbij de zoekmachines proberen te begrijpen welke informatie op deze pagina’s te vinden is. Ze gaan de content, video’s, foto’s… doornemen, alsook categoriseren. Daarom is het bijvoorbeeld belangrijk om Alt-tags toe te voegen aan afbeeldingen, om beelden zo verstaanbaar mogelijk te maken voor zoekmachines. Al deze informatie wordt vervolgens opgeslagen in een database. Bij het ingeven van een zoekopdracht, zal de zoekmachines deze index gebruiken om het meest relevante resultaten te vinden en vervolgens te tonen aan de gebruiker.

Hoe kan je pagina’s uitsluiten of beïnvloeden voor indexering?

Om zo overzichtelijk en relevant mogelijk over te komen kan je best niet alle informatie laten indexeren. Denk maar aan je testomgeving, bedankpagina’s na het inschrijven op een nieuwsbrief, de zoekfunctie van je website, pagina's met duplicated content, …

Vijf mogelijkheden om je crawl en/of index te beïnvloeden:

- Robots.txt

- Metarobots tags

- Canonical tags

- HTML of Hreflang tags

- Google Search Console

1. Robots.txt

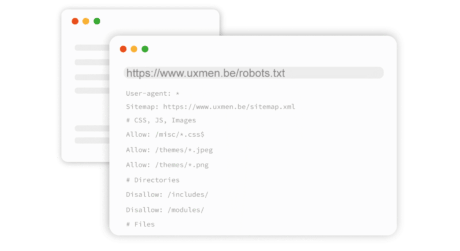

In een robotst.txt bestand kan een websitebeheerder aangeven aan zoekmachines welke pagina’s al dan niet geïndexeerd moeten worden. Om te weten te komen of je website al over zo’n bestand beschikt, kan je /robots.txt achter je domeinnaam plaatsen. Bv. uxmen.be/robots.txt.

Wat staat in een robots.txt bestand?

- User-agent: Voor welke zoekmachines de richtlijnen van toepassing zijn. Met een * geef je aan dat het van toepassing is voor alle zoekmachines.

- Sitemap: Een link naar je sitemap.

- Disallow: Hiermee sluit je pagina’s uit die voldoende aan de opgestelde richtlijn. Bv. alle admin-pagina’s.

- Allow: Hiermee kan een disallow-richtlijnen overschreven worden als je, binnen een uitgesloten directory, toch een specifiek Html-bestand wil laten crawlen en indexeren.

Een Robots.txt is inzichtelijk voor iedereen, dus als je niet wil dat eender wie een pagina kan vinden via jullie robots.txt bestand, dan kan je ze beter op een andere manier uitsluiten, namelijk via metarobots.

2. Metarobots tags

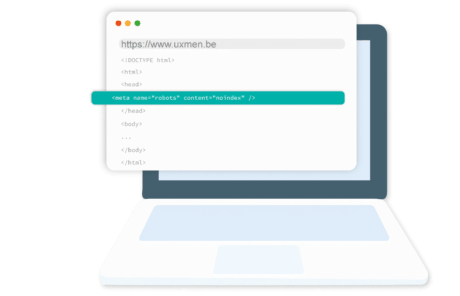

Met meta robots kan je op paginaniveau een actie aangeven aan een zoekmachine. Zo kan je bijvoorbeeld aangeven om een bepaalde pagina niet te laten indexeren of om geen van de verwijzende links op die pagina te laten volgen.

Een meta robot wordt toegevoegd aan de header sectie van een HTML webpagina. Afhankelijk van de mogelijkheden in je CMS, dien je hiervoor soms de hulp van een developer in te schakelen.

Meta robots zien er als volgt uit: <meta name=”robots” content=”<value>“.

- Meta Name: Hiermee kan je aangeven welke robots de pagina al dan niet mogen crawlen. Met “robots” geef je aan dat alle robots toegestaan zijn, dit kan je ook specifiëren, bv. enkel “Googlebots”.

- Content: via deze waarde geef je aan wat de bot al dan niet mag doen op de pagina. Er kunnen verschillende waarden ingevuld worden bij . De meest gebruikte waarden zijn “NoIndex” en “NoFollow”. Via “NoIndex” vertel je een crawler om de pagina niet op te nemen in de indexatie. “NoFollow” wil zeggen dat de bot geen enkele verwijzende link op de pagina mag volgen.

Wat is het verschil tussen Robots.txt en Metarobots tags?

- Robots.txt-bestanden sluiten een hele sectie van een website uit, je kan er bijvoorbeeld in één keer alle PDF’s van je website mee uitsluiten. Een metatag is efficiënter bij het uitsluiten op paginaniveau.

- Crawlers gaan bij een robots.txt-bestand de URL niet indexeren, maar de content mag wel gevonden worden. Via een metatag geef je aan dat de URL niet mag verschijnen in de zoekresultaten.

3. Canonical tags

Via deze tag in je html kan je aan Google vertellen dat url A en url B exact dezelfde inhoud hebben. Zo kan je bij een webshop bijvoorbeeld vier verschillende url’s hebben voor hetzelfde product omdat je via filtering onderscheid hebt in kleur, maat, merknaam, …

Al deze url’s hebben exact dezelfde content en Google is geen fan (understatement) van duplicated content. Via de canonical tag kan je aan de crawler laten weten welke pagina de originele is.

Stel dat url A de originele pagina is of de pagina die het beste presteert. Dan implementeer je een canonical tag in de <head> van url B, C en D. Die zal er als volgt uitzien:

<link rel=”canonical” href=”https://www.domeinnaam.be/dit-...” />

Het verschil tussen canonical tags en metatags is dat je bij canonical tags geen pagina’s gaat uitsluiten van de indexering. Je geeft gewoon aan dat de url A een duplicaat is van url B of andersom. Uiteindelijk zal Google in haar zoekresultaten nog steeds zelf kunnen beslissen welke landingspagina getoond wordt, de best presterende of meest relevante pagina voor de zoekterm. Google zal je niet afstraffen voor de duplicate content wanneer je gebruikmaakt van canonical tags.

4. HTML-tags

HTML-tags of Hreflang-tags zijn HTML-kenmerken die de taal en geografische targeting van een webpagina specificeren. Google kan via deze tags een onderscheid maken tussen gebruikers die surfen naar google.be of google.nl. Voor een Nederlandstalige surfer uit België zal Google zoekresultaten tonen van websites waarbij zowel taal als geografische targeting matcht met de surfer.

Dit verschil kan je duidelijk maken in de HTML-code van je website. De code ziet er als volgt uit:

<head>

<link rel="alternate" hreflang="nl-nl" href="" />

<link rel="alternate" hreflang="nl-be" href="" />

<link rel="alternate" hreflang="x-default" href="" />

</head>

Het doel van hreflang-tags is dus dat een zoekmachine naar de juiste landingspagina verwijst afhankelijk van de taalinstellingen van de surfer.

5. Google Search Console

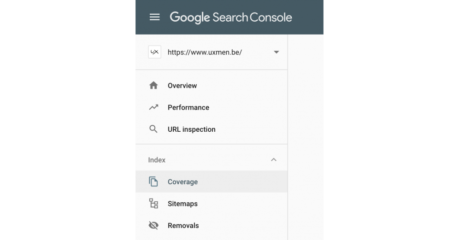

Google zou Google niet zijn, moest het geen tool aanbieden om haar eigen Google Zoek Index te kunnen beïnvloeden. Search Console is geen verplichting om te verschijnen in zoekresultaten van Google, maar via de tool krijg je wel inzichten in hoe Google naar je website kijkt. Aan de hand van die inzichten kan je vervolgens de prestaties van je website verbeteren.

Als je inlogt bij Google Search Console (GSC) kan je onder Index het tabje Coverage vinden. Hier zie je welke pagina’s errors vertonen en welke pagina’s wel of niet geïndexeerd worden en waarom. Ook je XML sitemap bestand kan je hier uploaden om de Google Index sneller in gang te trekken. Dit is vooral interessant voor nieuwe websites of wanneer je grote wijzigingen aan je website deed. GSC is verder nuttig om meer inzicht te krijgen in hoe Google naar jouw website kijkt en hoe gebruikers bij jouw website terechtkomen (via welke zoekwoorden, devices, locaties, …).

Ook via Search Console kan je URL parameters toevoegen. Eén URL kan verschillende parameters bevatten. Via de URL parameter tool kan je crawlinstellingen specifiëren. Een klassiek voorbeeld is pagination. Pagination wil zeggen dat je boven- of onderaan je websitepagina een nummering ziet: 1 > 2 > 3 > … > 13. Je komt dit vaak tegen bij blogartikels. Wat wil je dan indexeren? Het blogoverzicht en elk blogartikel afzonderlijk. Maar je wilt geen index van pagina’s zoals /blog?page=4. Die kan je gemakkelijk uitsluiten met behulp van de URL parameter tool van Google Search Console.

Maar let op, want het foutief uitsluiten van URL’s kan ertoe leiden dat veel pagina’s uit de zoekresultaten verdwijnen. Dit is heel technisch en je kan best advies vragen aan een SEO-expert.

Tot slot vind je onder Index ook het tabje Removals. Dit is de URL verwijder tool van GSC. Heb je bijvoorbeeld verouderde content of tijdelijke niet-geldige landingspagina’s, kan je snel een URL uit de index verwijderen. Let op, indien je wenst dat een pagina permanent uit de Google zoekresultaten verdwijnt, werk je beter met een noindex metatag.